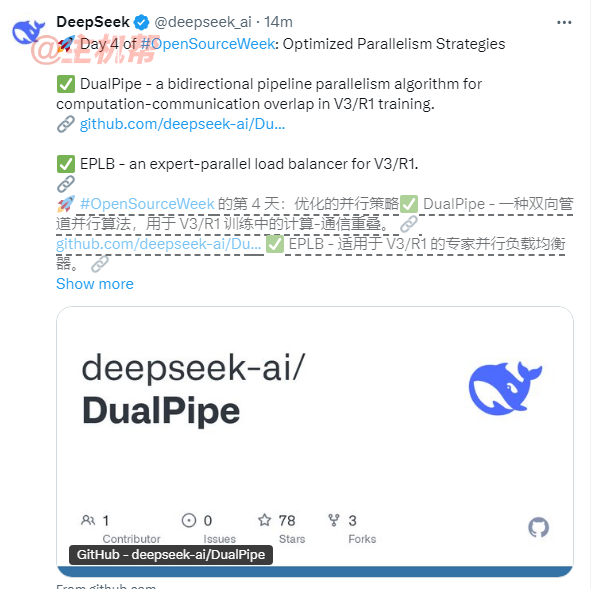

2024年2月27日——国内人工智能领域领军企业DeepSeek持续推进其“开源周”计划,今日正式公开第四批核心技术成果,聚焦优化并行策略,发布三项关键项目:双向管道并行算法DualPipe、专家并行负载均衡器EPLB,以及V3/R1架构下的计算-通信重叠分析工具。此次开源旨在解决超大规模模型训练中的效率瓶颈,为开发者提供可落地的技术方案。

DualPipe:双向流水线并行算法突破效率极限

作为DeepSeek-V3技术报告中提出的创新成果,DualPipe专为千亿参数级模型的分布式训练设计,通过双向数据流管道实现正向与反向计算-通信阶段的完全重叠。与传统单向流水线相比,该算法在反向传播过程中同步执行前向计算,显著减少了流水线中的“气泡”(即空闲等待时间),从而提升硬件利用率。

据技术文档显示,DualPipe通过智能调度机制动态协调计算与通信任务,尤其适配V3/R1架构的超大规模集群。这一设计不仅降低了训练迭代耗时,还为万亿参数模型的扩展提供了技术基础。

项目地址:https://github.com/deepseek-ai/DualPipe

EPLB:动态负载均衡器破解MoE训练难题

在混合专家模型(MoE)训练中,专家任务分配不均常导致部分GPU过载(即“热点专家”问题),而其他GPU资源闲置。DeepSeek开源的**专家并行负载均衡器(EPLB)**通过两项核心策略解决这一挑战:

- 冗余专家复制:针对高负载专家,EPLB动态创建副本,并通过启发式算法将其分配到不同GPU,确保计算资源均衡利用。

- 分组路由优化:结合DeepSeek-V3论文中的分组受限路由策略,EPLB优先将同一专家组的副本部署在同一计算节点内,最大限度减少跨节点通信流量。

开发者可通过开源代码库(eplb.py)直接调用负载均衡算法,快速部署适配自身硬件的专家分配方案。需注意的是,专家负载预测方法(如历史数据移动平均法)需结合具体场景实现。

项目地址:https://github.com/deepseek-ai/EPLB

计算-通信重叠分析:透明化训练优化过程

为帮助开发者深入理解V3/R1架构的并行策略,DeepSeek首次公开其训练与推理框架中的通信-计算重叠分析数据集。该数据集详细记录了3D并行(数据/流水线/张量并行)任务中的时空效率数据,涵盖通信延迟、计算任务调度等关键指标。

通过分析这些数据,开发者可精准定位计算与通信冲突的节点,针对性优化流水线调度策略。此举不仅降低了超大规模模型训练的调优门槛,也为社区研究提供了可复现的基准参考。

项目地址:https://github.com/deepseek-ai/profile-data

技术开源推动行业协同创新

DeepSeek此次开源的三大工具直击大模型训练的两大核心痛点——硬件利用率不足与动态负载失衡。行业分析指出,DualPipe与EPLB的组合应用,可显著降低千亿级模型的训练成本,而透明化的分析数据则为开发者自主优化提供了“路线图”。

值得关注的是,这些技术已在DeepSeek内部多个千亿参数模型训练中验证,其开源代码库支持灵活适配不同硬件环境。随着AI竞赛进入“效率为王”阶段,DeepSeek通过连续四日的关键技术开源,不仅展现了中国企业的研发实力,更以开放生态推动行业协同发展。

关于DeepSeek开源周

DeepSeek“开源周”计划自启动以来,已连续发布多批次大模型训练基础设施关键技术,涵盖分布式训练、高效推理、动态路由等领域。第五日收官成果将于明日揭晓,持续为全球AI开发者社区注入创新动力。